AI-dingsen Rabbit R1: – Sier noe om hvor vi kanskje er på vei

Nå som AI skal kunne bruke tjenestene våre, hva betyr det for oss utviklere? Petter Klingen Wright har sett på Rabbit R1 og konkurrentene.

Å lage tjenester på en måte som fungerer bra for både mennesker og roboter er ikke noe nytt.

The Verge mener at webben, slik den eksisterer i dag, er formet av Google. Søkemotorer, nyhetstjenester og mindre snille roboter står for ca. halvparten av trafikken på internett.

Men hva vil skje med tjenestene vi utvikler når disse robotene blir smartere?

Rabbit vs. Humane

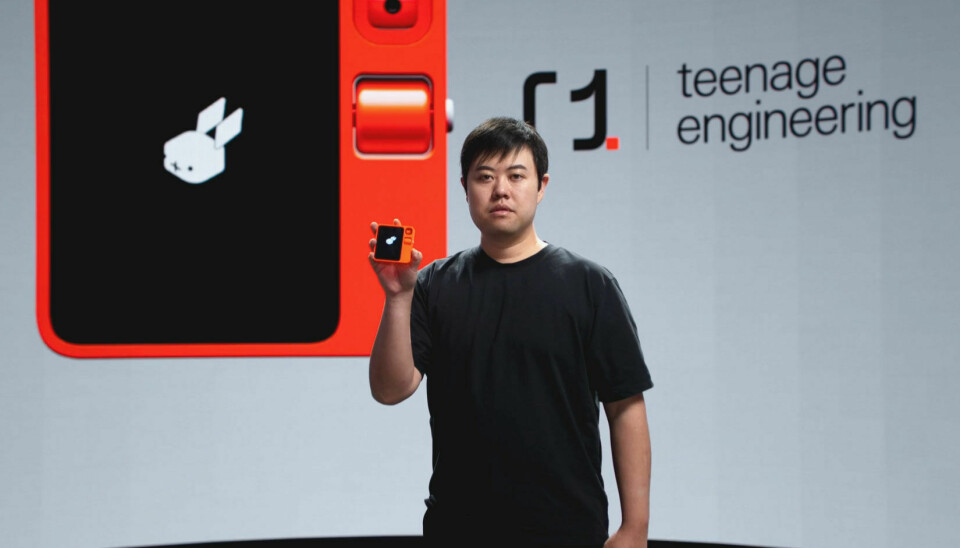

Under CES presenterte Rabbit en dings, Rabbit R1, ment for en post-smarttelefon fremtid der AI selvsagt er en sentral del av grensesnittet.

Med et lekent design, en prislapp på 199$ og en skjerm, så skiller den seg fra Humane sin AI Pin, som kanskje er det mest naturlige å sammenligne den med akkurat nå.

Men det er også en stor forskjell i hvordan det presenteres.

Der AI Pin blir presentert som noe skikkelig magisk, på den måten AI-produkter ofte blir presentert som magiske, forklarer Rabbit mer hvordan de tenker å bruke AI som et verktøy for å skape et godt produkt.

Large Action Model

Det er ofte stor forskjell på en demovideo og hvordan noe faktisk fungerer, men Rabbit sin presentasjon får meg til å tro at de er inne på noe her.

De har trent opp det de kaller en Large Action Model (LAM). Tjenester som ChatGPT bruker Large Language Models (LLMs) som får "forståelse" for tekst etter å ha blitt trent opp på massive mengder tekst.

Deres LAM skal med andre ord fungere for UI på samme måte som en LLM fungerer for tekst.

Dette kan bli en viktig del av hvordan brukere forholder seg til tjenestene vi lager.

LAM i praksis

Dette gjør at den ikke bare leser den innholdet – den forstår hva knapper gjør og kan trykke på de. I deres demo viser de frem noen forskjellige eksempler som Spotify, AirBnb og Uber, men litt av trikset her er at den kan trenes opp.

I en video viser de enkelt hvordan man kan trene den til å forstå flyten for å booke en AirBnb. De sier at den også vil fungere på native apper på mobil og data, i tillegg til nettsider. De mest populære tjenestene vil de trene selv, men de har også en "teach mode" der man kan trene den opp selv på mindre populære tjenester.

Dette vil si at dingsen kan bruke tjenester den aldri har sett før. Den kan også bety at den kan forstå hva som må gjøres der en knapp har flyttet seg. På samme måte som vanlige folk alltid forstår hva som har skjedd dersom en knapp har flyttet seg…

Design for roboter og mennesker

Jeg sier ikke at en dings til 199$ (som jeg ikke har prøvd) kommer til å endre hvordan webben eller programvare kommer til å bli utformet, men jeg syns den forteller en historie om hvor vi kanskje er på vei.

Det er nok de færreste som kommer til å bestille en feriebolig kun gjennom en AI. Men balansen av AI, enten gjennom tekst eller tale, og grafisk grensesnitt, kan bli en viktig del av hvordan brukere forholder seg til tjenestene vi lager.

Nye og smartere roboter kommer, det er det ingen tvil om, så det blir interessant å se er hvordan vi og brukerne våre kommer til å bruke dem.