Curl-skaper drukner i AI-feilrapporter: «Jeg har fått nok!»

Nå vil curl bannlyse alle som bruker AI til å rapportere inn feil.

– Vi har nådd en grense. Vi blir i praksis utsatt for et DDoS-angrep. Hvis vi kunne, ville vi ha fakturert dem for å kaste bort tiden vår, skriver Daniel Stenberg, mannen bak curl, i et LinkedIn-innlegg.

Curl er åpen kildekode, og prosjektet mottar rapporter om feil, sikkershull og sårbarheter via mange ulike kanaler. En av dem er HackerOne, en tjeneste der man kan melde inn sårbarheter og potensielt få utbetalt "finnerlønn" (bug bounties).

Det viser seg imidlertid at stadig flere av feilene som rapporteres inn via HackerOne er AI-genererte. Ofte meldes det inn feil som ikke er reelle, og de AI-genererte feilrapportene kan til og med inneholde referanser til kode som ikke eksisterer.

Akkurat som Seth Larson i Python Software Foundation, har Stenberg nå fått nok.

Godtar ikke AI-genererte bidrag

Nå vil ikke Stenberg og curl-teamet lenger bruke tid på å gå gjennom bugrapporter laget av AI.

– Nå er det nok. Jeg har fått nok. Jeg setter ned foten for denne galskapen, skriver Stenberg på LinkedIn.

Vi vil nå umiddelbart utestenge alle som sender inn rapporter som vi anser for å være AI-søppel.

Han krever nå at alle som sender inn sikkerhetsrapporter til HackerOne må svare på spørsmålet:

"Brukte du AI til å finne problemet eller til å generere denne innsendingen?"

De som svarer ja på spørsmålet, kan vente oppfølgingsspørsmål for å bevise at det er "faktisk intelligens" som har sendt inn bidraget.

– Vi vil nå umiddelbart utestenge alle som sender inn rapporter som vi anser for å være AI-søppel.

Aldri fått en gyldig AI-rapport

Stenberg skriver at curl aldri har sett en eneste gyldig sikkerhetshull-rapport generert med AI.

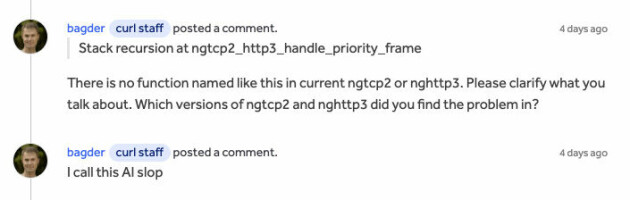

Dråpen som fikk begeret til å flyte over var en rapport på HackerOne med tittelen "Penetration Testing Report: HTTP/3 Stream Dependency Cycle Exploit".

Rapporten virker ved første øyekast troverdig og er velskrevet, men viser seg å inneholde referanser til funksjoner som ikke eksisterer. AI-en har med andre ord laget ikke-eksisterende funksjoner – med sikkerhetshull, som så er rapportert inn til HackerOne.

– Denne typen rapporter eksisterte ikke i det hele tatt for noen år siden, og mengden ser ut til å øke, skriver Stenberg på LinkedIn.

HackerOne mener AI er nyttig

Alex Rice, CTO og CISO i HackerOne, sier til Ars Technica at alle rapporter som inneholder hallusinerte sårbarheter eller innhold som ikke er korrekt, vil bli behandlet som spam av dem.

Men han mener likevel AI kan ha en nytteverdi:

– Vi mener AI, når det blir brukt på en ansvarlig måte, kan være et kraftig verktøy som kan øke produktivitet, skalerbarhet og gjennomslagskraft, sier Rice.

Han sier det skjer en rask innovasjon på AI-området og at de støtter sikkerhetsforskere som bruker AI til å forbedre kvaliteten og effektiviteten på jobben de gjør. Kvaliteten på sikkerhetsrapportene de får inn skal ifølge Rice ha økt, ettersom AI hjelper de som melder inn feil med å gjøre rapportene mer tydelige – spesielt for de som ikke har engelsk som morsmål.

– Det viktigste er å sørge for at AI forbedrer rapporten, i stedet for å introdusere støy, sier Rice.

Stenberg på sin side har mindre tro på AI – og sier til Ars Technica at han er glad for oppmerksomheten saken har fått:

– LLM-er kan ikke finne sikkerhetsproblemer, i hvert fall ikke slik det brukes her.