– Så gang på gang at ansatte lakk sensitiv informasjon til generativ AI

Startupen Prompt Shields bygger beskyttende lag mellom ansatte og AI-tjenester som ChatGPT.

– I dag brukes generativ AI bredt av ansatte – ofte uten tilsyn. Det fører til at sensitive data potensielt kan lekke til tredjepartsleverandører uten at ledelsen har innsikt eller kontroll.

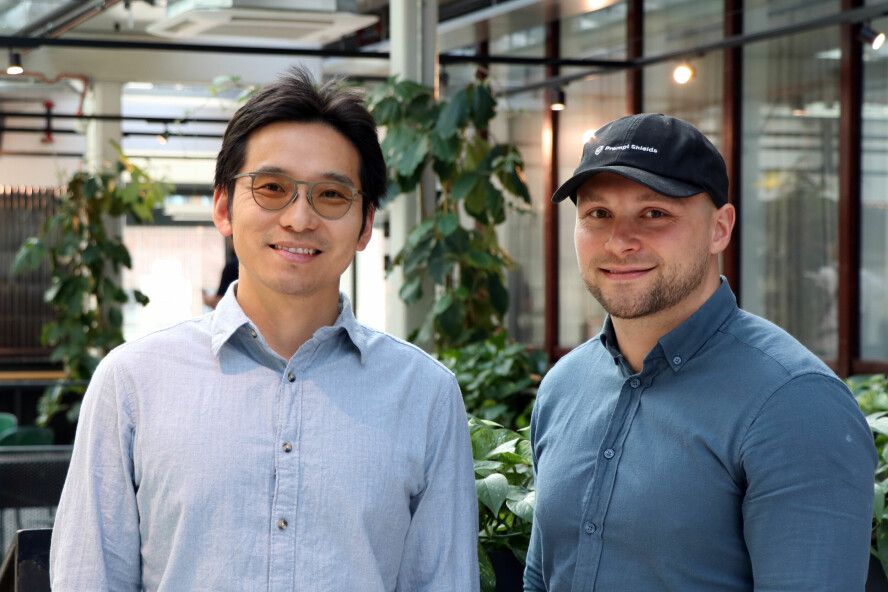

Det sier Tage Ringstad, COO (Chief Operating Officer) i det nyoppstartede selskapet Prompt Shields, til kode24. Han sa nylig opp jobben sin som investeringssjef i investeringsselskapet Antler for å bygge opp Prompt shields sammen med Jun Seki, som er CEO i selskapet.

Med Prompt Shields hevder de to å kunne hindre at data kommer på avveie når ansatte bevisst eller ubevisst sender data ut av bedriften via AI-tjenester som for eksempel ChatGPT.

Ansatte lekker data

CEO-en i selskapet, Jun Seki, har bakgrunn som utvikler og har startet opp flere selskaper. Blant annet grunnla han Poq, en plattform for elektronisk handel på mobil som ble solgt i 2019. Siden den gang har han både etablert nye selskaper og hatt flere CTO-roller – senest hos Antler på deres kontor i Rebel i Oslo.

– I løpet av Antler-tiden så jeg gang på gang at ansatte lakk sensitiv informasjon og persondata til generativ AI, sier Seki.

Han forteller at han har snakket med mer enn 90 CISO-er (IT-sikkerhetssjefer), og funnet ut at alle prøvde å håndtere dette problemet på ulike måter – men at det ikke fantes noen god løsning.

Mens Seki jobbet i Antler undersøkte han derfor hvilke muligheter som fantes for å hindre datalekkasje fra ansatte til AI-systemer.

Da han ikke fant noen gode løsninger, gikk han sammen med Tage Ringstad, som hadde mye erfaring med finansiering av oppstartsselskaper. I tillegg fikk han med seg utviklere han har jobbet med tidligere – og startet Prompt Shields.

I løpet av Antler-tiden så jeg gang på gang at ansatte lakk sensitiv informasjon og persondata til generativ AI.

Lag mellom bedrift og AI

Prompt Shields skal fungere som et sikkerhetslag som ligger mellom de ansatte i bedriften og generativ AI, forteller Ringstad.

Kundene kan være mange ulike typer selskaper, men i første omgang har Prompt Shields konsentrert seg om "regulerte virksomheter", som typisk kan være bank, finans, helsevesen eller juridisk sektor.

– Vi utvikler teknologi som gjør det mulig for virksomheter å ta i bruk AI-verktøy uten å risikere datalekkasjer, prompt injection-angrep eller brudd på GDPR og EUs nye AI Act, sier Ringstad.

Løsningen fungerer ved å kjøre lokale, små språkmodeller (SLM – Small Language Model ) "on-prem". Så får brukerne tilgang til et chatte-grensesnitt i en native app for Windows eller Mac-OS der de kan velge mellom ulike tredjeparts språkmodeller, for eksempel OpenAI GPT-4o eller Claude, og taste inn sine "prompts" på vanlig måte.

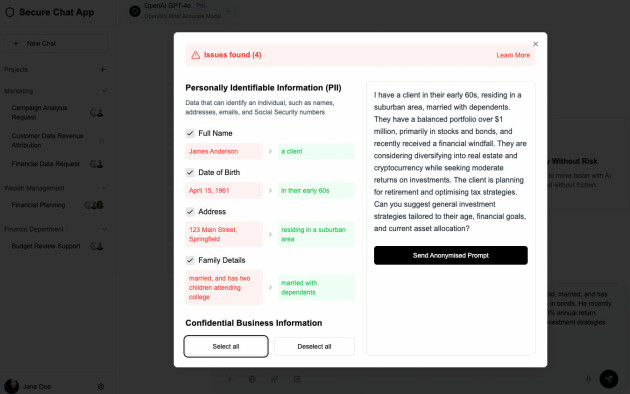

Takket være den lokale SLM-en vil Prompt Shields oppdage om en bruker for eksempel ved et uhell taster eller limer inn sensitive data. Prompt Shields vil da automatisk identifisere de sensitive dataene og kunne bytte dem ut med mer anonyme data før prompten sendes videre til den eksterne, store språkmodellen.

Løsningen vil også kunne hente ut data fra bedriftens systemer, for eksempel finansielle data – og eventuelt gi beskjed om at du må søke om å få tilgang til dataene.

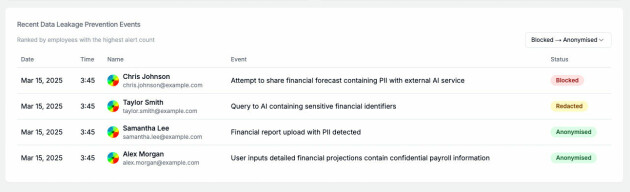

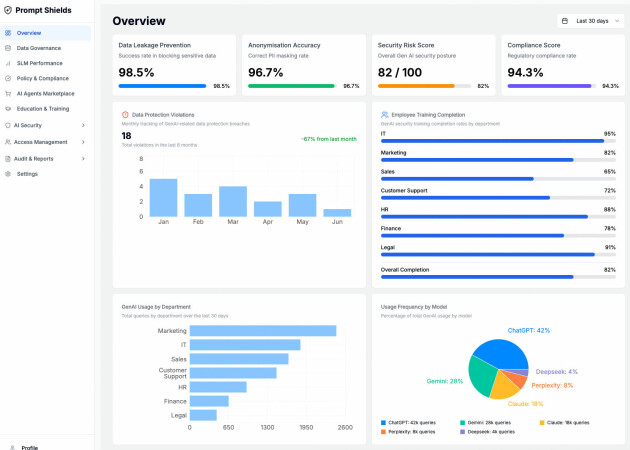

Bedriften skal få et dashboard der de kan sette opp policies, se logger, få statistikk og mye mer.

Det er også utviklet en nettleserutvidelse som anonymiserer data for å unngå at sensitive data ved uhell limes inn i for eksempel tekstfelter i nettleseren og sendes ut av bedriften.

Bygget på Microsoft-stack

Seki forteller at løsningen de bygger i stor grad er basert på Microsoft-teknologi:

- Frontend: Swift på MacOS, C# på Windows, Next.js, React og Tailwind CSS på web

- Backend: Python og FastAPI på Azure Functions

- Database og lagring: Neon (serverless PostgreSQL), Azure Blob Storage, Azure Cosmo DB

- Autentisering: Auth0

- Analyse og monitorering: Firebase Analytics, egne CISO-dashboards

- AI-modeller: «Regex-based PII detection (in-house rules engine) + Microsoft Presido Azure OpenAI (for context-aware redaction and LLM-based analysis) OpenAI GPT-4, Claude, Gemini, Perplexity AI for model comparisons (AI Foundry)»

- Security & Governance: Integrasjon med Microsoft Purview for data-klassifisering og styring

– Vi bygget hele stacken vår på Azure, og er partner med Microsoft. Mange av utviklerne våre er Microsoft-eksperter, sier Seki.

– Vi ønsker å være det sikkerhetslaget som alle bedrifter trenger. Vår visjon er at vi om fem år skal være den pålitelige leverandøren for AI-sikkerhet, avslutter Ringstad.