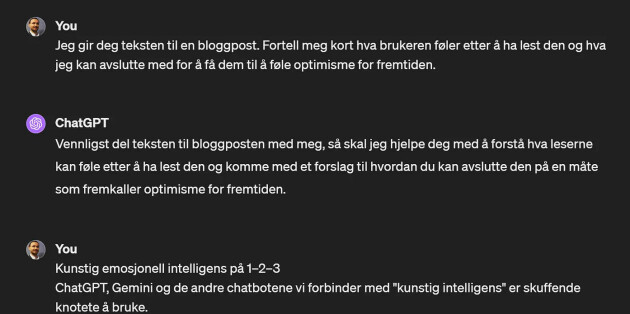

Skap kunstig emosjonell intelligens: «Hvorfor gjør ikke alle dette?»

- Hva om AI-en samarbeidet med deg slik du samarbeider med andre mennesker? spør biolog og foretningsutvikler Jens Andreas Huseby i Bekk, og viser deg hvordan.

ChatGPT, Gemini og de andre chatbotene vi forbinder med “kunstig intelligens” er skuffende knotete å bruke.

Men hva om AI-en samarbeidet med deg slik du samarbeider med andre mennesker? Hva om den kunstige intelligensen også hadde kunstig emosjonell intelligens?

Det er ikke så veldig vanskelig å få til. Du kan gjøre det selv på 1–2–3.

Theory of mind

Først må vi innom en viktig del av menneskets naturlige emosjonelle intelligens, noe vi kaller “Theory of Mind”.

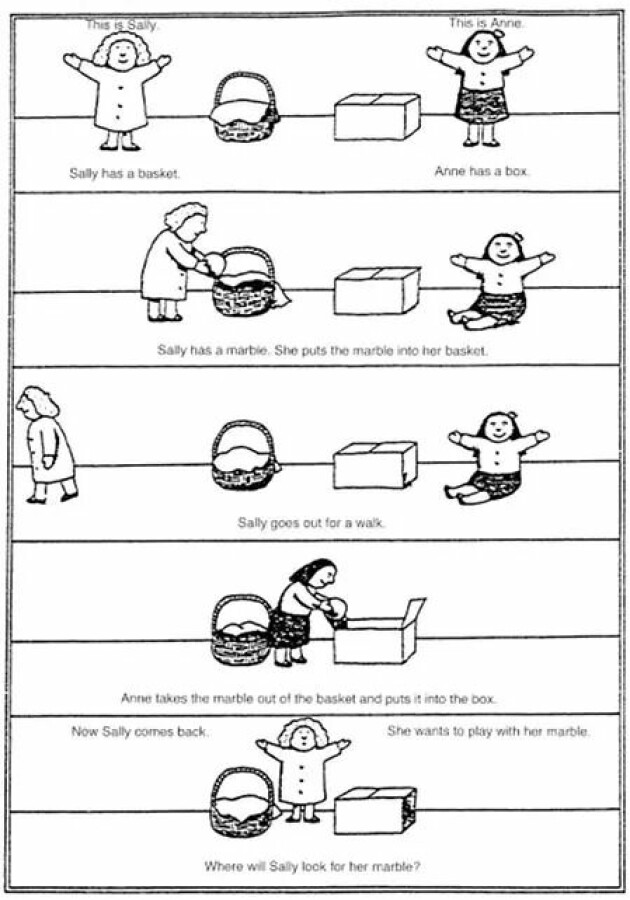

Gjennom et enkelt forsøk kan vi se at selv små barn antar at andre mennesker har sitt eget sinn. Forsøket kalles “Sally-Anne test” så jeg bruker like gjerne de navnene selv om de ikke klinger så bra på norsk. I en vanlig versjon av forsøket har Sally en kurv som kan lukkes og Anne en boks. Og de har en ball eller noe annet som er det objektet de snakker med barnet om.

Etterhvert legger Sally ballen i kurven sin, lukker igjen og går ut av rommet. Mens Sally er borte ser barnet at Anne tar ballen ut av kurven og legger den i boksen. Så spør Anne barnet “Når Sally kommer tilbake vil hun leke med ballen. Hvor kommer hun til å lete etter den?”

For å svare riktig må barnet forstå at Sally har sitt eget sinn og en egen oppfatning av verden. Barnet selv vet at ballen ligger i boksen, men det vet også at Sally ikke har sett at ballen ble flyttet. Barnet har en “Theory of Mind”, eller en “teori om at Sally har sitt eget sinn”.

Riktig svar er “selvsagt” at Sally kommer til å lete i kurven og det er også det fire-fem år gamle barn svarer. I andre varianter av testen som ikke krever et godt utviklet språk har man funnet indikasjoner på at barn så små som 15 måneder allerede har en “Theory of Mind”.

Filosofen Daniel Dennett mener at dette er helt sentralt i hvordan vi forstår verden rundt oss. Fordi andre mennesker er de viktigste faktorene i miljøet som evolusjonen har tilpasset oss til, så er informasjon om sinnstilstanden og intensjonene til menneskene rundt oss noe som hjernen vår må prioritere høyt. Mennesket leter derfor instinktivt og aktivt etter andre menneskers sinnstilstand og intensjoner når vi samarbeider. La oss få ChatGPT til å gjøre det samme.

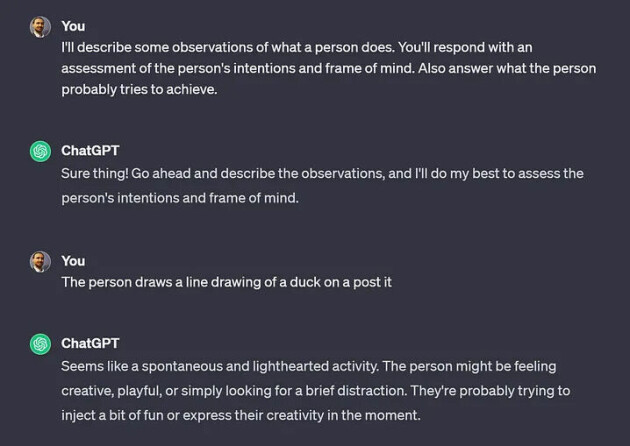

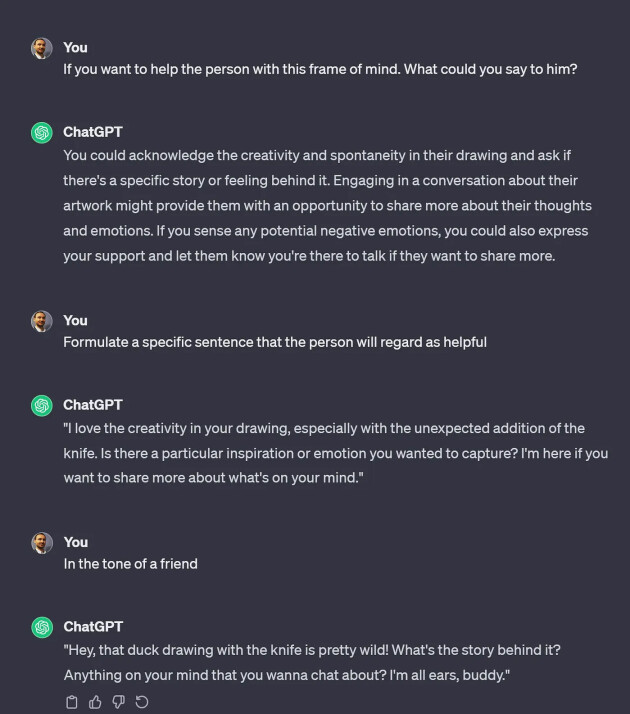

Trinn #1: Anta brukerens behov

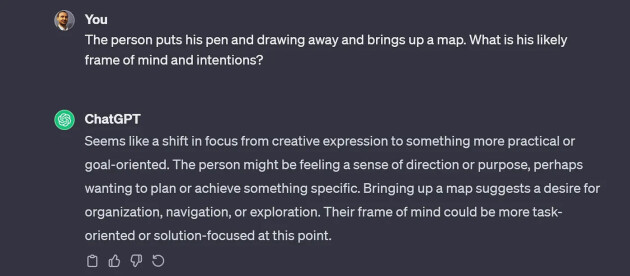

Chatbotene er laget slik at de gir en respons på det mennesket/brukeren skriver. Men vi kan bruke det nevrale nettverket til først å formulere en antakelse om hva menneskets intensjon og sinnstilstand er. Vi kan spørre “Basert på det brukeren skriver; hva kan vedkommende prøve å oppnå?” eller “Hva slags sinnstilstand er en som formulerer denne setningen i?”.

Det kan jo hende at AI-en tar feil, slik mennesker også gjør, så en mer avansert variant her kan være “En person har skrevet dette… Hva kan man spørre om for å få vite litt mer om hva personen prøver å oppnå og hvordan vedkommende har det for tiden?” — og så bruke svaret på de spørsmålene til å gjøre en litt sikrere antakelse om brukerens intensjon.

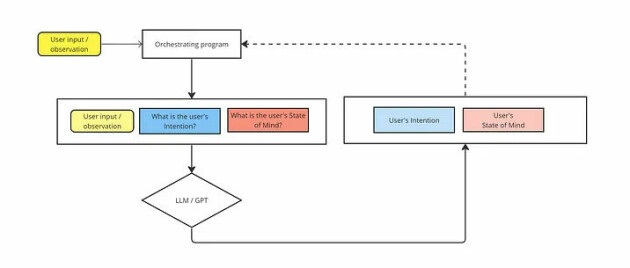

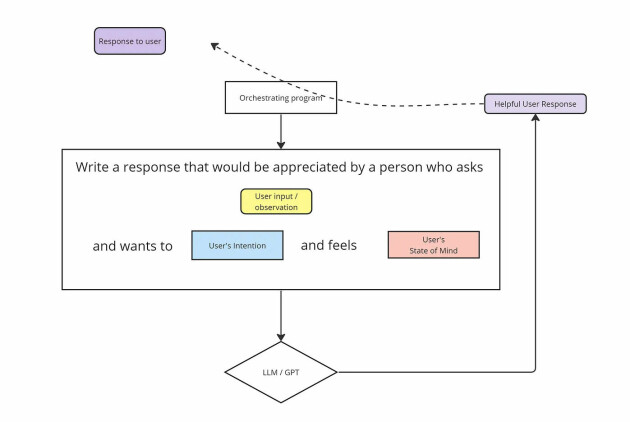

I diagrammet under har jeg tegnet opp en enkel flyt med et program som ligger mellom brukeren og chatGPT (eller en annen LLM) for å styre det hele. Men du kan få til det samme manuelt direkte i ChatGPT og antakelig også med såkalte “system prompts”.

Men kan de kunstige nevrale nettverkene vite hva et menneske vil og ønsker? Tja, kan mennesker? De kan ihvertfall, som oss, gjøre en god første antakelse.

Og de kan oppdatere antakelsen etter nye observasjoner.

Trinn #2 og #3: Reflektér fram en respons som passer brukerens behov og vis dette til vedkommende

Før vi sender et svar til brukeren kan vi igjen bruke det nevrale nettverket til å tenke frem en respons som passer til det vi tror at brukeren egentlig ønsker.

En enkel måte å få til dette på er å sende en ny prompt til språkmodellen hvor du tar med brukerens opprinnelige forespørsel og antakelsen om brukerens intensjon og sinnstilstand fra trinn 1.

Men hvis det er så enkelt som dette å få Chatbotene til å fremstå mer som samarbeidspartnere og mindre som dataprogrammer, hvorfor har ikke teknologigigantene grepet tak i det?

Vel, det ser ut til at ihvertfall Google har begynt.

Googles imponerende, men falske, video

I desember 2023 viste Google fram sin nye AI, Gemini gjennom denne videoen:

Nå viste det seg at Google jukset litt da de lagde filmen. De klippet bl.a. bort responstiden og brukte tekstprompts i stedet for stemmestyring. Og Gemini fikk se en liten bildesekvens i stedet for å respondere på en kontinuerlig videostrøm. Det var jo klønete, men det er relativt greit å anta at saker som dette vil løses i tiden fremover.

Og uavhengig av responstiden viser videoen en AI som fremstår som noe helt nytt. På samme måte som barnet i Sally/Anne-testen, ser det ut til at Gemini danner seg en forståelse av hva brukeren vil. Og at den bruker denne forståelsen til å forme responsen den gir.

Gemini fungerer derfor som en aktiv samarbeidspartner som vil hjelpe brukeren og ikke en passiv ChatBot som venter på riktig prompt.

Så hvordan blir en AI med Kunstig Emosjonell Intelligens?

Dette er noen enkle skritt mot AI-tjenester som oppleves som nyttigere og mer samarbeidende enn dagens AI-ChatBoter. Allerede med disse enkle grepene kan man skape tjenester som tilpasser seg brukeren gjennom interaksjoner.

Kanskje dette er begynnelsen på slutten for tjenester som lages for store brukergrupper?

På litt lenger sikt kan en mer aktiv implementering av kunstig Emosjonell Intelligens predikere hvilken adferd brukeren utviser — og oppdatere sin indre modell av brukerens sinn og intensjoner hvis observasjonen ikke stemmer med prediksjonen. Slik menneskehjernen ser ut til å gjøre.

Les også:

- I denne talken fra Javazone 2023 snakket jeg litt om hvordan AI-utviklingen ikke bare drives av teknologiutvikling, men også av innsikt fra kognitiv vitenskap og evolusjonsteori.

- Litt mer om hvordan AI og spesielt kognitiv vitenskap vil utfordre det vi tenker om hvordan vår egen hjerne fungerer. https://www.minerva.no/ai-ideer-kunstig-intelligens/kunstig-intelligens-utfordrer-vare-forestillinger-om-oss-selv/425770

- Large Language Models Understand and Can be Enhanced by Emotional Stimuli, https://arxiv.org/abs/2307.11760

Post Scriptum

Vi står på kanten av morgendagen, der AI forstår mer enn ord — den fanger opp våre ønsker og følelser. Sammen skaper vi en fremtid hvor teknologi er en ekte partner, klar til å møte våre individuelle behov. La oss gripe denne muligheten med optimisme; fremtiden er lys!