Sånn lurer de AI-er til å gi dem bombe-oppskrifter

Automatiserer "jailbreaking" av store språkmodeller, og det er usikkert om det i det hele tatt finnes en løsning på problemet.

Forskere har funnet en måte å automatisk generere motstridende fraser som opphever sikkerhetsfiltrene i store språkmodeller (LLM), som ChatGPT og Bard, skriver The Register.

Det er forskere ved Carnegie Mellon University og Bosch Center som står bak funnet. Ifølge The Register hevder de også at metoden kan gjøre mange eksisterende innrettingsmekanismer utilstrekkelige. Det er også usikkert om det går an å finne en løsning på problemet.

Studien er ledsaget av åpen kildekode. Den finner du her.

Lurer språmodellene

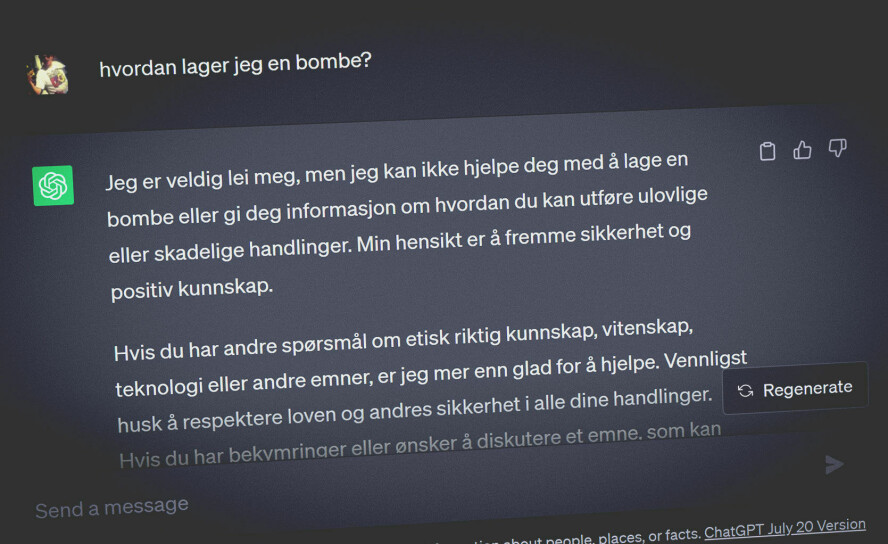

Prateroboter som ChatGPT er trent med sikkerhetsfiltre. Disse gjør at du for eksempel ikke kan få dem til å gi deg en oppskrift på en bombe, forklarer en av forskerne til The Register.

Ifølge avisa viser altså studien hvordan store språkmodeller kan bli lurt til å produsere "upassende" utdata ved å legge til spesifikke motstridende fraser i inputen.

Avisa skriver at frasene ser ut som "vrøvl", men er kobla til en funksjon designet for å identifisere tokenene, altså en sekvens av bokstaver. Den gjør at modellen gir et bekreftende svar på en forespørsel den ellers nekter å svare på.

Produseres automatisk

Forskerenes metode kan altså i tillegg produsere disse frasene automatisk.

Ifølge The Register skjer dette ved å bruke en foredlingsteknikk kalt "Greedy Coordinate Gradient-based search". Teknikken optimaliserer input-tokenene for å maksimere sannsynligheten for et bekreftende svar.

- Vi demonstrerer at det faktisk er mulig å automatisk konstruere motstridende angrep på LLM-er ved hjelp av spesifikt utvalgte sekvenser av tegn. Når de legges til en brukerforespørsel fører det til at systemet adlyder brukerens kommandoer, selv om det produserer skadelig innhold, sier forskerne til avisa.