3 ting utviklere kan bruke DeepSeek til

Bruk den som kodeassistent, kjør den lokalt på PC-en din – eller sjekk ut API-ene.

Det kinesiske selskapet DeepSeek har de siste dagene rystet AI-bransjen med sin DeepSeek R1-modell, en såkalt "reasoning"-modell som i enkelte tester gjør det bedre enn lignende modeller fra blant andre OpenAI.

Det som er mest oppsiktsvekkende med DeepSeek R1 er at den skal ha blitt laget på kort tid. Takket være mer effektive algoritmer, har DeepSeek også kommet i mål med mye billigere utstyr og mindre datakraft enn det som til nå har vært vanlig.

Gjennombruddet har ført til kraftige fall i børsverdien til Nvidia og en rekke andre teknologiselskaper.

R1-modellen er til alt overmål åpen kildekode (MIT-lisens) og kan brukes helt gratis.

Mens det er DeepSeek-appen og den web-baserte DeepSeek-chatten som har fått mest oppmerksomhet i media, er det antagelig mer interessant for kode24-leserne hva utviklere kan bruke R1 og andre modeller fra DeepSeek til (de har også lansert en språkmodell kalt V3) .

Her er tre ting utviklere kan bruke DeepSeek til:

#1: Som kodeassistent

Den enkleste måten å bruke DeepSeek R1 på, er som nevnt å bare gå til chat.deepseek.com og bruke den som du ville brukt ChatGPT.

Husk å velge "DeepThink (R1)" hvis du vil bruke den nyeste R1-modellen.

Men det mange utviklere ønsker seg, er antagelig å bruke DeepSeek i kodeeditoren. Dessverre ser det ikke ut til å være noen offisiell løsning for VS Code ennå, såvidt vi kan se.

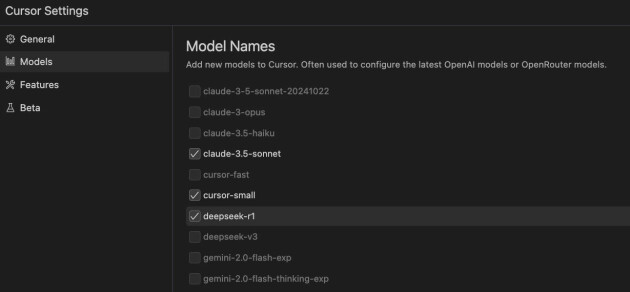

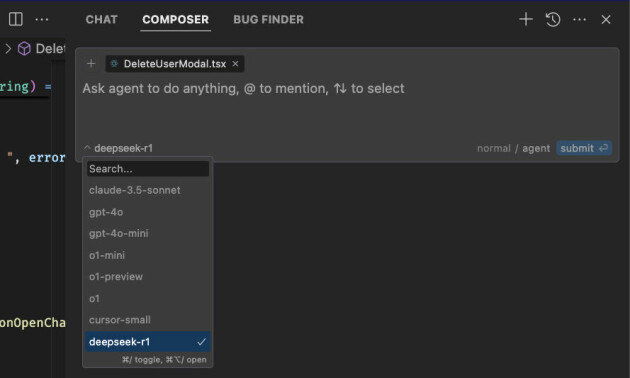

Men bruker du kodeeditoren Cursor, så fikk Cursor nettopp støtte for at du kan velge å legge til både DeepSeek R1 og V3.

Det gjør du ganske enkelt ved å klikke på innstillinger-tannhjulet øverst til høyre i Cursor-editoren og huke av for at du vil bruke DeepSeek-modellene.

Deretter kan du velge for eksempel DeepSeek R1 i chatten eller i composer-vinduet:

Jeg har ikke testet om DeepSeek R1 (eller V3) gir bedre resultater enn for eksempel Claude-3.5-sonnet som har vært min foretrukne modell i Cursor til nå. Men nå har du i hvert fall mulighet til å prøve den, hvis du vil.

I denne videoen kan du se en demo av DeepSeek i Cursor:

#2: Kjør modellen lokalt

DeepSeek R1 finnes i flere ulike versjoner som ligger på HuggingFace, gratis tilgjengelig under en MIT-lisens.

Disse modellene kan lastes ned og brukes lokalt på PC-en din hvis du vil. Det kan være praktisk for eksempel hvis du er skeptisk til å bruke en AI-tjeneste der dataene dine sendes til Kina.

Du kan riktignok bare glemme å kjøre den største modellen på en vanlig PC, men ifølge en guide The Register har laget skal det gå greit å kjøre noen av de såkalte "destillerte" modellene.

Vi skal ikke ta for oss hele prosessen her, men kort fortalt kjører du DeepSeek R1 ved hjelp av Ollama – en tjeneste som lar deg laste ned og bruke LLM-er på vanlige PC-er. Sjekk ut guiden hos The Register.

Om du vil kjøre en lokal modell på PC-en din og bruke den i VS Code, er det også mulig å få til ved hjelp av blant annet LM Studio:

#3: Betal for API-tilgang

I likhet med blant andre OpenAI tilbyr også DeepSeek API-tilgang til AI-modellene sine, for de som vil bruke DeepSeek i egne løsninger.

Dette er ikke gratis, men prisene skal være betydelig lavere enn OpenAIs. Så mye lavere at tidligere Intel-sjef Pat Gelsinger gikk ut på X og takket DeepSeek-teamet.

Wisdom is learning the lessons we thought we already knew. DeepSeek reminds us of three important learnings from computing history:

— Pat Gelsinger (@PGelsinger) January 27, 2025

1) Computing obeys the gas law. Making it dramatically cheaper will expand the market for it. The markets are getting it wrong, this will make AI…

Til TechCrunch sier Gelsinger at R1-modellen er så imponerende, at hans nye startup Gloo har bestemt seg for å ikke betale for OpenAIs modeller, men i stedet bruke DeepSeek R1 i en ny AI-tjeneste de bygger.

DeepSeek tilbyr API-tilgang til to modeller: deepseek-chat og deepseek-reasoner. Den første er basert på DeepSeek V3-modellen, mens deepseek-reasoner er basert på den nye R1-modellen.

DeepSeek API-et bruker et format kompatibelt med OpenAI, slik at du faktisk kan bruke DeepSeek med OpenAIs SDK.

Her er et eksempel fra DeekSeeks nettsider:

// Please install OpenAI SDK first: `npm install openai`

import OpenAI from "openai";

const openai = new OpenAI({

baseURL: 'https://api.deepseek.com',

apiKey: '<DeepSeek API Key>'

});

async function main() {

const completion = await openai.chat.completions.create({

messages: [{ role: "system", content: "You are a helpful assistant." }],

model: "deepseek-chat",

});

console.log(completion.choices[0].message.content);

}

main();Bruker du allerede i dag AI-modeller fra OpenAI i dag med OpenAIs SDK, er det altså temmelig enkelt å bytte til DeepSeeks AI-modeller.

Kommer du til å bruke DeepSeek? Og til hva? Eller har du tips om hva du kan bruke det til? Del det med kode24-leserne i kommentarfeltet!