AI-ekspertene er klare: Vi trenger norske språkmodeller

En norsk modell kan respektere opphavsrett, og vi kan vite hvordan den fungerer. Spørsmålet er om vi har datakraft nok.

Giganter som OpenAI, Google, Meta og AWS har brukt – og bruker – vanvittig mye penger, datakraft og energi på å utvikle store språkmodeller (LLM-er).

Så hvorfor i alle dager skal da Norge investere tid og penger på å utvikle egne språkmodeller? Er det ikke bortkastet tid, penger og datakraft?

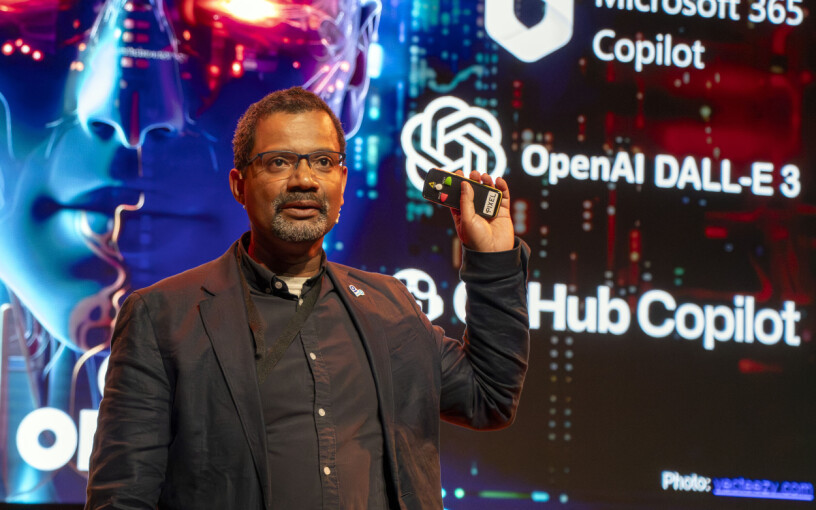

Heri Ramampiaro er instuttleder og professor ved Institutt for datateknologi og informatikk ved NTNU, og leder for Norwegian Open AI-Lab. På AI+-konferansen i Halden argumenterte han for at det er flere gode grunner til at Norge bør trene opp egne modeller.

Det kanskje viktigste argumentet hans er at man selv får kontroll på hvilke data modellene er trent opp på. Dette i motsetning til om man bruker andres modeller, som i prinsippet bare er en "svart boks": Man vet ikke hvorfor ChatGPT svarer som den gjør, og har heller ikke mulighet til å finne det ut.

En norsk modell er ikke lansert ennå, fordi vi bruker mye tid på å sikre at vi respekterer opphavsretten.

Må respektere opphavsrett

Ramampiaros Norwegian Open AI-Lab jobber via SFI NorwAI (Senter for Forskningsbasert Innovasjon) med å utvikle en egen språkmodell, trent opp på norsk tekst.

Som treningsdata er det blant annet brukt data fra kilder som Nasjonalbiblioteket og fra mediehus som Schibsted. Det er lagt ned mye manuelt arbeid for å sikre at man har kontroll på hvor dataene kommer fra, og at man har rett til å bruke dem.

– En norsk modell er ikke lansert ennå, fordi vi bruker mye tid på å sikre at vi respekterer opphavsretten for alle data som er brukt til å trene modellen, sa Ramampiaro fra scenen på AI+.

Det har riktignok blitt vist frem og snakket om flere norske språkmodeller som er under utvikling – som NorGPT som ble vist frem på Arendalsukea i høst, og en modell som utvikles av UiO.

Ramampiaro sier at selskaper i Norge som ønsker å bruke generativ AI og maskinlæring stort sett har tre alternativer i dag:

- Bruke hyllevare fra Google, OpenAI eller andre, som OpenAIs ChatGPT. Det er enkelt og billig – men har ingen kommersielle fordeler.

- Bruke forhåndstrente modeller fra andre, men med egne unike data for å "fin-tune" modellen til å passe din bruk. Det er billigere, og gjør AI tilgjengelig for mindre organisasjoner.

- Klassisk maskinlæring. Her trener man opp modeller fra bunnen av, noe som krever enormt med både data, ressurser og penger.

Ramampiaro mener at det i en akademisk setting er lurt å drive med klassisk maskinlæring, altså det tredje alternativet. Selv om dette koster mye ressurser, er det viktig for å drive grunnforskningen fremover.

Han mener også det beste alternativet for de fleste som ønsker å benytte seg av AI, som små og mellomstore bedrifter, likevel er alternativ to, med forhåndstrente modeller som kan tilpasses eget bruk.

Hva er vitsen?

Så hva er egentlig poenget med å lage egne språkmodeller for Norge eller Norden?

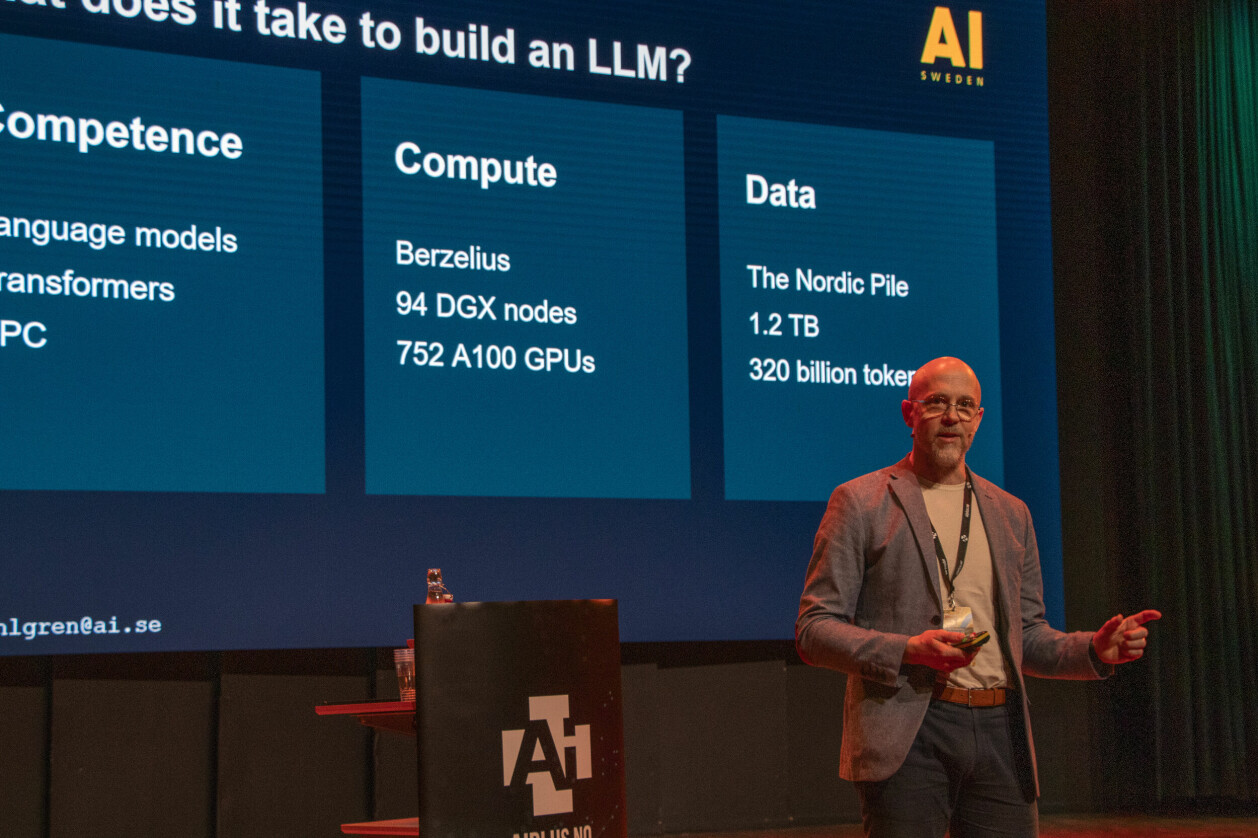

Magnus Sahlgren er forskningssjef ved AI Sweden, som er Sveriges nasjonale senter for kunstig intelligens. Sahlgren leder et initiativ for å trene opp store språkmodeller for de nordiske språkene.

Fra scenen i Halden gjorde han et poeng ut av at når man bruker språkmodeller trent opp av amerikanske giganter, så vet man ingenting om hvordan modellene fungerer eller hvilke data de er trent opp på. Dette ønsker de ofte heller ikke å fortelle av konkurransehensyn.

– Men skal vi bruke det i for eksempel skoler, så må vi vite hvordan de fungerer.

Sahlgren mener også det er viktig at vi i Norden har kompetansen som trengs for å bygge AI-modeller.

– Selv om vi ikke skal bygge systemene selv, må vi forstå hvordan de virker. Og en fin måte å få kompetanse på, er ved å prøve å bygge det selv, sa Sahlgren.

Representativt for Norden

Mens mange har vært bekymret for at AI skal ha fordommer, mente Sahlgren dette var noe som kunne håndteres. Han var mer bekymret for at innholdet modellene var trent på ikke skulle være representativt for det vi her i Norden er opptatt av. Er de ikke det, vil ikke modellene gi de svarene vi ønsker.

– Vi prøver å være så representative i datautvalget som mulig.

Sahlgren mener også det er viktig for et land å ha tilgang på egen AI-teknologi.

– Det er en ustabil verden der ute. Vi vet ikke når eksportrestriksjoner når oss. Og hvis de gjør det, så trenger vi å ha teknologi her hos oss.

Første LLM for Norden

I 2022 lanserte Sahlgren og hans team det som ifølge han skal være den første LLM-en for Skandinavia: GPT-SW3. Modellen er åpen kildekode og ligger tilgjengelig på Hugging Face.

Den er trent opp på et datasett med 320 milliarder tokens på svensk, dansk, norsk, islandsk, engelsk, samt programkode. Et "token" i denne sammenhengen kan være ord i en setning. Hele datasettet kalles for The Nordic Pile, og inneholder totalt 1,2 terabyte med data.

Det er trent opp flere versjoner av modellen, fra ganske små på 126 millioner tokens til den aller største som er på 40 milliarder tokens. Det er også gjort det Sahlgren kaller "instruksjons-tuning" for å lære modellen hvordan den skal oppføre seg.

Selv om modellen først og fremst ble bygget for Sverige, fungerer den for alle germanske språk, og er som nevnt trent opp også på norske data. Gjennom et samarbeid med NTNU i Norge er målet at det skal bli en beste mulig språkmodell for alle nordiske språk.

Har ikke kraftige nok maskiner

Det å trene opp en modell som GPT-SW3 krever enormt med datakraft, i tillegg til mye treningsdata og kompetanse. Måten AI Sweden har løst dette på er ved å samarbeide med Nvidia og få tilgang til både maskinvare og programvare gjennom dem.

– Du kommer til å trenge en superdatamaskin. I Sverige har vi bare én som er kraftig nok, Berzelius. Det er en fantastisk ressurs, sa Sahlgren.

Berzelius-superdatamaskinen består av 94 Nvidia DGX-noder og 752 Nvidia A100-GPU-er. Men til tross for at dette er noe av det kraftigste som er å oppdrive av superdatamaskiner på vår kant av verden, så måtte Sahlgren og kollegaene legge beslag på rundt en tredjedel av den totale kapasiteten da de skulle trene GPT-SW3.

– Nå jobber vi med neste trinn, som er multimodalitet.

Med det menes LLM-er som ikke bare kan forstå tekst, men også lyd og bilder. Til det kreves mye mer datakraft.

Mens en LLM som skal forstå bare tekst krever milliarder av tokens, snakker man om billioner – altså tusen ganger mer – om LLM-ene også skal trenes på bilder og lyd.

Til alle land: Kjøp GPU-er! Du får ikke nok av dem. Dere bør bygge superdatamaskiner overalt!

For å klare å trene opp disse modellene, trengs kraftigere superdatamaskiner enn det man har tilgang på i Sverige – og så vidt vi vet også Norge. Sahlgren fortalte at de for å løse dette har innledet et samarbeid med EuroHPC, som har flere av de største superdatamaskinene i Europa.

Sahlgren mener vi generelt har for få kraftige superdatamaskiner i Norden og i Europa ellers, og kom med et lite hjertesukk til slutt:

– Til alle land: Kjøp GPU-er! Du får ikke nok av dem. Dere bør bygge superdatamaskiner overalt!